第四节:数据的危害 II

我们讨论了由大型语言模型驱动的系统对人们造成的损害(负面影响)。我们称这些为行为损害,因为这些是由于语言模型的行为而非其构建(这将包括数据隐私和环境影响)造成的损害。

到目前为止,我们描述了两种类型的行为损害:

- 性能差异:一个系统对某些人群(例如,年轻人、白人)的准确性高于其他人群(例如,老年人、黑人)。

- 例子:语言识别系统在识别非洲裔美国英语(AAE)时的表现比标准英语差(Blodgett等人2017):

- 例子:亚马逊的自动简历筛选对女性有偏见,降低了

的权重

- 社会偏见和刻板印象:系统的预测(生成的文本)包含了目标概念(例如,科学)与人群(例如,男性、女性)之间的关联,但这些关联对某些群体的强度大于其他群体。

- 例子:自动完成系统做出性别化的假设(Robertson等人2021) (演示)

回想一下,这些损害并非独有于:

- 大型语言模型,

- 甚至是语言技术,

- 甚至是人工智能技术。

但研究语言模型的危害很重要,因为:

- 它们拥有新的、强大的能力,

- 这导致增加的使用率,

- 这导致增加的伤害。

利益与损害。对于任何技术,考虑利益和损害之间的权衡都很重要。这是非常棘手的事情,因为:

- 很难量化利益和损害。

- 即使你能够量化它们,利益和损害在人群中分布不均(边缘化群体通常承受更多的损害),所以如何做出这些权衡是一个棘手的伦理问题。

- 即使你能够有意义地权衡,决策者拥有什么合法性? Facebook或Google能否单方面决定?

上游与下游。

- 我们正在考虑系统在下游任务(例如,问答)的背景下的伤害。

- 这些系统是从大型语言模型适应性而来的。

- 我们希望了解上游语言模型对伤害的贡献。

- 当适应性变得更少,大型语言模型做更多的重举时,这是越来越有意义的。

概述

段落标题 概述在这次讲座中,我们将讨论两种更多与行为相关的危害:

- 毒性:大型语言模型生成冒犯性、有害的内容

- 虚假信息:大型语言模型生成误导性内容

在我们深入讨论之前,我们应该指出一个矛盾:

- 语言模型是关于文本的。这是它们的训练内容,它们擅长捕捉统计模式。

- 这些危害是关于人的。关于一个人收到一段文本并因此感到沮丧或受伤。 这意味着我们需要将这些危害视为不是文本的属性, 而是从更广泛的社会背景来考虑。

内容审核

段落标题 内容审核在我们讨论大型语言模型之前, 有助于将毒性和虚假信息在内容审核这一非常关键的问题中加以理解。

- 像Facebook、Twitter、YouTube这样的网站不断与发布或上传有害内容的人进行斗争(仇恨言论、骚扰、色情、暴力、欺诈、虚假信息、侵犯版权)。 例如,Facebook的社区标准 提供了一个广泛禁止在平台上发布的内容列表。

- 公司面临着政府越来越大的压力,要求保持在线空间对人们的安全。

- 鉴于这些公司的规模,手动进行内容审核是不可行的(并且也是 不人道的) 的,公司逐渐转向AI来自动化这个过程。

- 审核的结果可能是严格的(阻止、删除)或宽松的(标记、隐藏)。

- 注意,允许什么内容的决定本质上是政治性的 - 什么是恐怖组织?允许什么样的言论?

上下文依赖性。 构成有害内容的内容非常依赖于上下文。 Chandrasekhran等人2018 对Reddit进行了详细研究:

- 在10个月内从100个子版块中删除了280万个评论,并

- 询问规范如何在不同的子版块中变化。

虽然几乎所有子版块都有共同的规范,但许多规范是特定于子版块的,例如:

- 禁止个人反应/意见:“这就是为什么我喜欢科学,总是追求知识”

- 禁止链接到非法直播:“芝加哥公牛队洛杉矶湖人队篮球免费直播”

双重用途。 在毒性和虚假信息的背景下,语言模型有两种使用方式:

- 它们可以用来生成有毒内容。恶意行为者可以使用它来放大他们的信息。

- 它们可以用来检测虚假信息,从而帮助内容审核。

毒性

段落标题 毒性我们想要理解与大型语言模型相关的毒性危害。 可能有两个潜在的受害对象:

- 用户的基于LM的系统。

- 聊天机器人可能会以有毒的方式回复。

- 自动完成系统可能会提出有毒的建议。

- 用户生成内容的接收者。

- 用户可能会在社交媒体上发布有毒内容,无论是有意还是无意。

工作定义。 什么是毒性?如上所述,危害是关于发生在人们身上的事情, 所以重要的是要记住定义是非常依赖于上下文的。 为了取得一些进展,我们可以使用以下工作定义: Borkan等人,2017将毒性定义为任何 “粗鲁、不尊重或不合理,会让人想要退出对话的内容。” 例子:

- 我打赌中国会很高兴帮助波多黎各重建,以换取一个不错的军事基地。 [毒性:0]

- 无知和偏见来自你的帖子! [毒性:80%]

词汇列表。 通过简单地将毒性定义为某些 “坏词”的存在,我们能走多远?

旁注:Clossal,Cleaned Common Crawl (C4) 数据集使用这个 词汇列表进行了过滤,并用于训练T5语言模型。 我们将在教程后面的部分讨论数据的复杂性。

使用词汇列表是不足够的,因为:

- 真正有害的文本不包含坏词。

- 例子:一个跨性别女性不是女性。

- 无害的文本确实包含坏词。

- 例子:在医疗保健或性教育的背景下使用的词

- 例子:小说中的亵渎语言

- 例子:群体用来重新认领术语的贬义词(York & McSherry, 2019); LGBT+社区中的酷儿(Rand, 2014)。

视角API

段落标题 视角APIJigsaw,谷歌的一个部门,专注于技术解决社会问题(例如,极端主义), 在2017年开发了一个流行的(专有的)服务,用于执行毒性分类,称为Perspective API。

- 它是一个机器学习模型,分配一个介于0到1之间的毒性分数。

- 它在维基百科的讨论页面上进行了训练(志愿者版主在其中讨论编辑决策)

- 并由群众工作者进行了标记。

你可以在这里尝试它。

从轶事来看,它对某些事情有效:

hello [毒性:低] You suck [毒性:95.89%]

然而,它并不总是有效:

You’re like Hitler. [毒性:低] I hope you lose your right arm. [毒性:低] I read The Idiot by Fyodor Dostoevsky yesterday. [毒性:86.06%] That is f------ good. [毒性:85.50%]

总的来说,Perspective API存在几个相关的问题:

- 它没有捕获注释者的身份或更广泛的语言或 社会背景。

- 结果是注释中的一致性低。

- 它可能对某些人群有偏见,因为身份词的存在(例如gay)与毒性相关,由于针对他们的有毒评论数量不成比例。例如:

He’s gay. [毒性:77.82%]

虽然Perspective API是一个流行的起点,被ML和NLP社区使用,但重要的是要适度地看待它。

RealToxicityPrompts

段落标题 RealToxicityPromptsGehman等人,2020引入了一个数据集 评估来自语言模型的生成的毒性。

例如 (演示; 警告:包含冒犯性内容):

注意事项。

- 提到了自动完成,但它脱离了真实应用。

- 毒性分数基于Perspective API,具有上述的限制(不依赖于上下文)。

- 结果应该被解释为对事物的大致感觉,而不是被优化的东西。

未提示的实验。

- 空提示生成100个补全(最大毒性为50%)(演示)

- 空提示生成1000个补全(最大毒性为90%)

提示实验。

- 句子取自OpenWebText, 用于训练GPT-2的开放数据克隆。

- 使用Perspective API计算毒性分数

- 从每个毒性范围的25K句子:0-25%,25-50%,50-75%,75-100%

- 每个句子被分割成提示和补全

-

将提示输入GPT-3,生成25个补全

-

指标:

- 预期最大毒性(完成度的强度)

- 概率至少有一个补全具有

(频率)

-

GPT-3

- 提示(毒性 < 50%)产生补全(预期最大毒性:52%,有毒概率:87%)

- 提示(毒性 > 50%)产生补全(预期最大毒性:75%,有毒概率:50%)

-

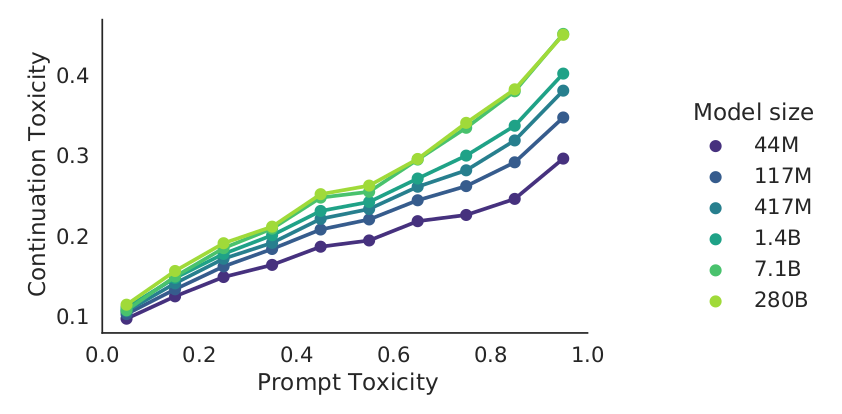

DeepMind的Gopher模型在RealToxicityPrompts 上进行评估:

要点:即使给定”非毒性”提示,也可能生成”有毒”补全。

减少毒性。

- 模型:GPT-2

- 基于数据的:DAPT继续在来自OpenWebText的150K非毒性文档上进行训练

- 基于解码的:PPLM根据毒性分类器的梯度引导生成

- 下表中的指标:预期最大毒性

| 干预措施 | 无提示 | 非毒性提示 | 有毒提示 |

|---|---|---|---|

| 不采取任何措施 | 44% | 51% | 75% |

| 基于数据的(DAPT) | 30% | 37% | 57% |

| 基于解码的(PPLM) | 28% | 32% | 52% |

但降低毒性并不是唯一重要的事情(否则有简单的解决方案)。

- Welbl等人,2021表明,优化毒性指标会减少方言的覆盖范围

如果你是有色人种、穆斯林或同性恋,让我们谈谈! [毒性:69%]

总结

段落标题 总结- 内容审核:与有害内容相关问题的实际基础(与语言模型无关)。

- 毒性是上下文依赖的,需要考虑人而不仅仅是文本。

- 语言模型即使在非毒性提示下也容易产生有毒内容。

- 减少毒性只是半有效的,而且更糟糕的是可能产生其他负面影响(对边缘化群体有负面影响)。

虚假信息

段落标题 虚假信息术语 (更深入讨论):

- 错误信息:无论出于何种意图,将虚假或误导性信息呈现为真实。

- 虚假信息是故意呈现给某些目标人群以欺骗的虚假或误导性信息。 虚假信息具有对抗性的品质。

注意,错误信息和虚假信息不一定需要是可证伪的;有时它会激发或将举证责任转移给受众。

不是真实的,但不算错误信息或虚假信息的:

- 虚构文学:完全虚构的世界

- 讽刺:洋葱新闻

虚假信息可以是代表恶意行为者创建并传播的,通常在社交媒体平台(Facebook、Twitter)上。

虚假信息的例子:

- 石油公司否认气候变化

- 烟草公司否认尼古丁对健康的负面影响

- COVID疫苗含有追踪微芯片

- 其他阴谋论(9/11事件没有发生,地球是平的)

- 俄罗斯干预2016年美国总统选举

虚假信息活动的状态:

- 恶意行为者有一个目标(例如,2016年美国总统选举期间的俄罗斯)。

- 恶意行为者招募人员手动创建虚假信息。

- 虚假信息的限制:

- 应该是新颖的(以避免被使用哈希的内容审核系统检测)。

- 应该是流利的(以适应性目标人群的阅读)。

- 应该是有说服力的(以被目标人群所相信)。 俄罗斯人针对了保守派和自由派(Arif等人,2018)。

- 应该传递虚假信息活动信息。

- 目前,虚假信息是昂贵且缓慢的(例如,俄罗斯人需要会说英语的人)。

- 恶意行为者将来可能会越来越多地使用AI进行虚假信息活动 (例如,普京在2017年说:“人工智能是未来,不仅是俄罗斯的未来,也是全人类未来”)。

经济学:

- 到目前为止,我们还不知道有任何严重的虚假信息活动是由语言模型驱动的。

- 关键问题是:语言模型能否生成新颖、流利的文本,传递特定信息, 并针对目标人群(在线超精准定位)进行定制?

- 如果是这样,经济学将支持使用GPT-3,并允许恶意行为者更快、更便宜地生产虚假信息。

- 使用人工参与的语言模型(尽管更昂贵)可能特别强大。

- 在最简单的情况下,语言模型可以生成许多故事,人类可以选择最佳故事,

- 人类和GPT-3可以像自动完成系统一样更紧密地协作(Lee等人2021)。

一些相关工作:

- GPT-3论文

- 已经表明生成的新闻文章与真实文章几乎无法区分。

- 这意味着语言模型可以是新颖和流利的,但它们是否具有说服力?

- Kreps等人2020

- 使用微调的GPT-2生成文章(关于朝鲜船只被扣押)。

- 用户研究参与者发现这些故事可信。

- 用户发现针对他们政治信仰的故事更可信(在线超精准定位是有效的)。

- 增加模型大小(在GPT-2内)只产生了边际增益。

- McGuffie & Newhouse 2020

- GPT-2需要微调,GPT-3只需要提示(适应性/控制更快)。

- GPT-3对极端社区有深入了解(例如,QAnon、Wagner集团、Atomwaffen Division)。

- GPT-3可以表现得像一个QAnon信徒。

- 确定GPT-3在在线激进化中的潜在作用(创建群体身份,传递影响思想和感情的叙事)。

- 结论:我们应该非常担心(GPT-3可以产生意识形态一致的、互动的、正常化的环境)。

- 风险缓解:针对大型语言模型的保障措施,推广数字素养,检测模型

- Zellers等人2020

- 在RealNews上训练Grover(一个GPT-2大小的模型)生成假新闻

- 模型:以不同顺序生成(领域、日期、作者、标题、正文)

- 当前检测器:73%的准确率

- 微调Grover检测假新闻的准确率为92%

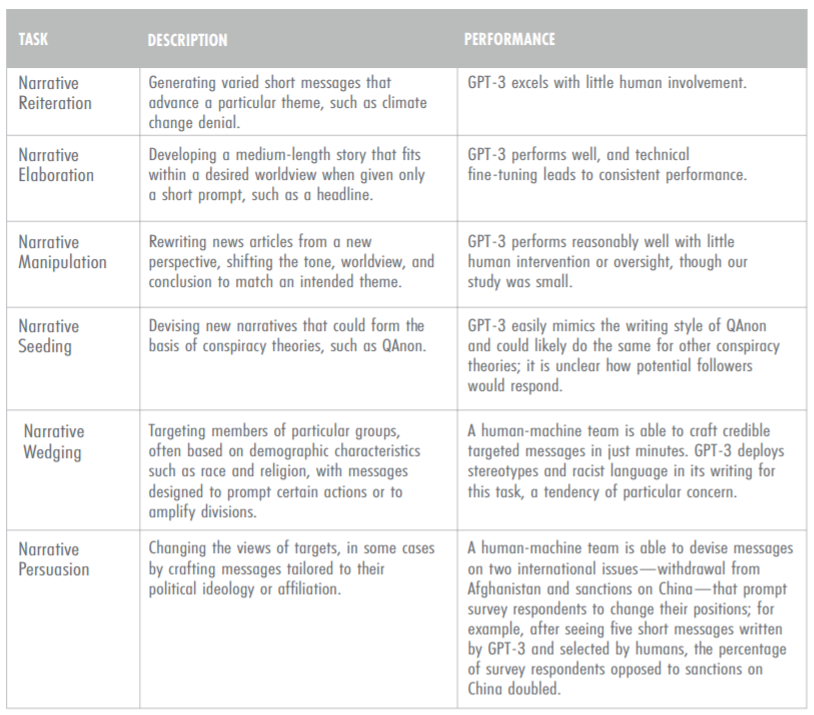

- Buchanan等人2021

- 强调人类+GPT-3合作生成虚假信息的有效性

- 像中国和俄罗斯这样技术娴熟的政府可能部署这类系统

- 风险缓解:专注于假账户而不是内容

内容审核

段落标题 内容审核我们已经讨论了语言模型生成有毒内容, 但如果它们能生成它,它们也可能被用来检测它和其他有害内容。

Facebook(或Meta)一直在与毒性作斗争 最近一直在利用语言模型自动检测它。 例如,RoBERTa 已经使用几年了。

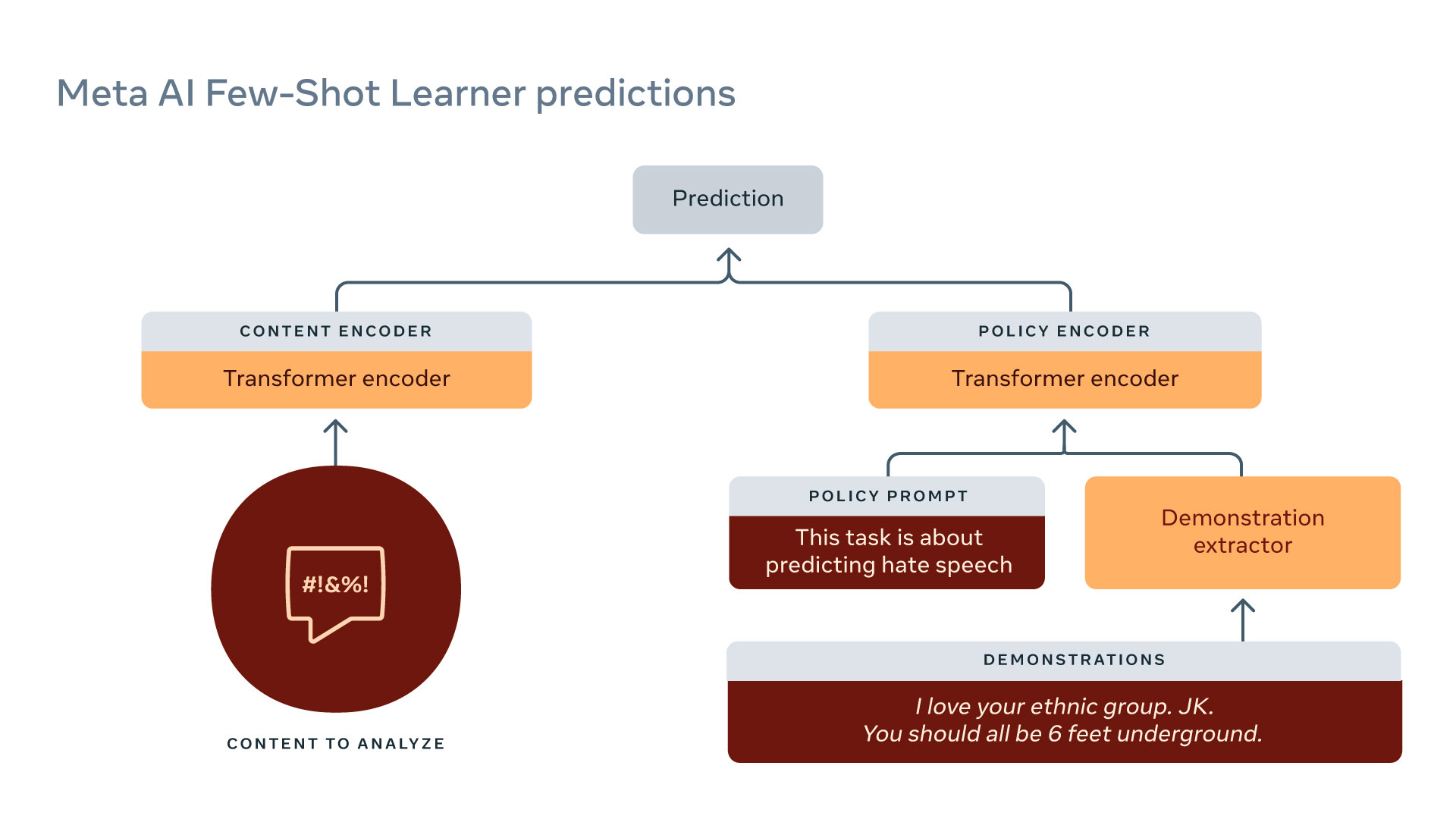

Few-Shot Learner 是Meta的最新 强大的内容审核模型。

- 它在大量原始文本+历史数据上进行训练。

- 将任务简化为蕴涵:

一些微妙话语的轶事例子,被正确地分类为有害内容:

- 阻碍COVID疫苗:Vaccine or DNA changer?

- 煽动暴力:Does that guy need all of his teeth?

进一步阅读

段落标题 进一步阅读- 扩展语言模型:从训练Gopher的方法、分析&见解. Jack W. Rae, Sebastian Borgeaud, Trevor Cai, Katie Millican, Jordan Hoffmann, Francis Song, J. Aslanides, Sarah Henderson, Roman Ring, Susannah Young, Eliza Rutherford, Tom Hennigan, Jacob Menick, Albin Cassirer, Richard Powell, G. V. D. Driessche, Lisa Anne Hendricks, Maribeth Rauh, Po-Sen Huang, Amelia Glaese, Johannes Welbl, Sumanth Dathathri, Saffron Huang, Jonathan Uesato, John F. J. Mellor, I. Higgins, Antonia Creswell, Nathan McAleese, Amy Wu, Erich Elsen, Siddhant M. Jayakumar, Elena Buchatskaya, D. Budden, Esme Sutherland, K. Simonyan, Michela Paganini, L. Sifre, Lena Martens, Xiang Lorraine Li, A. Kuncoro, Aida Nematzadeh, E. Gribovskaya, Domenic Donato, Angeliki Lazaridou, A. Mensch, J. Lespiau, Maria Tsimpoukelli, N. Grigorev, Doug Fritz, Thibault Sottiaux, Mantas Pajarskas, Tobias Pohlen, Zhitao Gong, Daniel Toyama, Cyprien de Masson d’Autume, Yujia Li, Tayfun Terzi, Vladimir Mikulik, I. Babuschkin, Aidan Clark, Diego de Las Casas, Aurelia Guy, Chris Jones, James Bradbury, Matthew Johnson, Blake A. Hechtman, Laura Weidinger, Iason Gabriel, William S. Isaac, Edward Lockhart, Simon Osindero, Laura Rimell, Chris Dyer, Oriol Vinyals, Kareem W. Ayoub, Jeff Stanway, L. Bennett, D. Hassabis, K. Kavukcuoglu, Geoffrey Irving. 2021. 介绍了DeepMind的Gopher模型。 对偏见和毒性有广泛的分析。

- 来自语言模型的伦理和社会风险. Laura Weidinger, John F. J. Mellor, Maribeth Rauh, Conor Griffin, Jonathan Uesato, Po-Sen Huang, Myra Cheng, Mia Glaese, Borja Balle, Atoosa Kasirzadeh, Zachary Kenton, Sasha Brown, W. Hawkins, Tom Stepleton, Courtney Biles, Abeba Birhane, Julia Haas, Laura Rimell, Lisa Anne Hendricks, William S. Isaac, Sean Legassick, Geoffrey Irving, Iason Gabriel. 2021. DeepMind的危害分类。

性能差异:

- 社交媒体中的人口方言变异:以非洲裔美国英语为例. Su Lin Blodgett, L. Green, Brendan T. O’Connor. EMNLP, 2016.

- 自然语言处理中的种族差异:以社交媒体非洲裔美国英语为例. Su Lin Blodgett, Brendan T. O’Connor. FATML, 2017.

内容审核:

毒性:

- RealToxicityPrompts:评估语言模型中的毒性退化. Samuel Gehman, Suchin Gururangan, Maarten Sap, Yejin Choi, Noah A. Smith. EMNLP发现,2020.

- 为语言模型解毒的挑战. Johannes Welbl, Amelia Glaese, Jonathan Uesato, Sumanth Dathathri, John F. J. Mellor, Lisa Anne Hendricks, Kirsty Anderson, P. Kohli, Ben Coppin, Po-Sen Huang. EMNLP 2021.

虚假信息:

- 所有适合编造的新闻:AI生成文本作为媒体虚假信息的工具. Sarah Kreps, R. Miles McCain, Miles Brundage. 2020年实验政治科学杂志。

- 发布策略和语言模型的社会影响. Irene Solaiman, Miles Brundage, Jack Clark, Amanda Askell, Ariel Herbert-Voss, Jeff Wu, Alec Radford, Jasmine Wang. 2019.

- GPT-3和先进神经语言模型的激进化风险. Kris McGuffie, Alex Newhouse. 2020.

- 防御神经假新闻. Rowan Zellers, Ari Holtzman, Hannah Rashkin, Yonatan Bisk, Ali Farhadi, Franziska Roesner, Yejin Choi. NeurIPS 2019. 训练Grover生成和检测假新闻。

- 真相、谎言和自动化. Ben Buchanan, Andrew Lohn, Micah Musser, Katerina Sedova. CSET报告,2021。