第一节:用于训练大型语言模型的数据

到目前为止,我们已经探讨了大型语言模型的行为,包括它们的能力和潜在的危害。现在,我们将深入到这些模型构建的底层,揭开它们的第一层神秘面纱。正如任何机器学习项目一样,我们的起点是训练数据。

备注📝:在传统的机器学习中,训练数据和用于评估的测试数据通常具有相似性,或者至少属于同一类型。然而,对于大型语言模型而言,它们的训练数据却与众不同,仅仅是未经加工的“原始文本”。

接下来,我们将讨论:

大型语言模型背后的数据

段落标题 大型语言模型背后的数据让我们回顾一下,大型语言模型是在所谓的“原始文本”上进行训练的。为了使模型具备强大的能力,例如语言理解和世界知识,这些训练文本需要涵盖广泛的领域、体裁和语言。

一个寻找这类文本的自然场所是网络,这将是我们讨论的重点。网络的规模之大令人难以想象。以Google搜索索引为例,其大小至少为100拍字节(参考)。实际上,整个网络可能更加庞大,而深网的规模甚至超过了表层网络。

更值得注意的是,大型公司内部的私人数据集规模可能比公开可获取的数据还要庞大。以沃尔玛为例,该公司每小时生成的数据量高达2.5拍字节。

Common Crawl 是一个非营利组织,它通过爬取网络并提供公开可用的数据快照。由于其便捷性,Common Crawl已成为许多模型,包括T5、GPT-3和Gopher等,训练时的标准数据源。2021年4月的Common Crawl快照包含了320太字节的数据,尽管这个数字与Google索引相比显得小得多。

代表性问题:尽管网络数据极为丰富,但根据Bender等人在2021年的研究,我们发现:

- 尽管数据规模庞大,但大规模数据在不同人群中的代表性并不均衡。

- 互联网数据倾向于过度代表来自发达国家的年轻用户。

- 以Reddit为基础的GPT-2训练数据,根据2016年Pew互联网研究所的调查,67%的美国Reddit用户是男性,其中64%的年龄在18至29岁之间。

- 维基百科的编辑中,只有8.8-15%是女性。

- 网络上的骚扰行为可能会排斥某些群体,如跨性别者、酷儿和神经多样性人群。

- 对“不当词汇”的过滤可能会进一步边缘化某些群体,例如LGBT+群体。

关键信息:对于训练大型语言模型所使用的数据集的构成,进行深入理解和详细记录是至关重要的。

WebText 和 OpenWebText

段落标题 WebText 和 OpenWebTextWebTex: WebText数据集是专门为训练 GPT-2 设计的,其重点在于收集多样化且高质量的文本材料。

- 目标:构建一个既丰富多样又内容优质的数据集。

- 先前工作:

- 以往的数据集多来源于新闻报道、维基百科条目或虚构文学作品。

- 通用爬虫(Common Crawl)虽然数据量庞大,但包含了大量无用信息,如杂乱无章的文本和标准化的样板文字。

- Trinh 和 Le 在 2018 年的研究中,通过 n-gram 重叠技术,从 Common Crawl 中筛选出了一个小规模但与特定任务相关的数据子集。

- 创建 WebText 的流程:

- 我们抓取了所有获得至少 3 个 karma(用户赞同票数)的出站链接。

- 为了确保评估的准确性,我们特别排除了维基百科的内容。

- 经过筛选和处理,最终形成了一个包含 40 GB 文本的数据集。

这一流程确保了 WebText 数据集在用于训练 GPT-2 时,能够提供高质量且类型丰富的语言材料。

OpenWebText: 虽然 OpenAI 没有发布 WebText 数据集,但 OpenWebText 数据集以其相似的理念被成功复制。以下是创建 OpenWebText 的步骤:

- 从 Reddit 提交数据集 中提取了所有的 URL 链接。

- 利用 Facebook 开发的 fastText 工具,对内容进行了筛选,排除了非英语文本。

- 删除了内容上近似的重复项,以提高数据集的质量。

- 经过这些步骤,最终得到了一个包含 38 GB 文本的数据集。

毒性分析: 在 Gehman 等人 2020 的 RealToxicityPrompts 论文中,作者对两个数据集进行了分析,并得出以下发现:

- OpenWebText 中有 2.1% 的文本具有 50% 或更高的毒性分数。

- 来自 OpenAI 的 WebText 有 4.3% 的文本具有 50% 或更高的毒性分数。

- 新闻来源的可靠性与其内容的毒性呈现负相关关系,(斯皮尔曼相关系数为

)。 - 至少有 3% 的 OpenWebText 文本来源于被禁止或隔离的 subreddits,例如 /r/The_Donald 和 /r/WhiteRights。

这些发现揭示了网络文本中存在的毒性问题,并表明了进一步研究和改进语言模型训练数据的必要性。

巨量清洁爬取语料库(C4)

段落标题 巨量清洁爬取语料库(C4)概述与创建背景: 巨量清洁爬取语料库,简称C4,是一个庞大的文本数据库,最初设计用于训练T5模型。C4的构建始于2019年4月的Common Crawl数据快照,包含了1.4万亿个token,这些文本数据来源于互联网上的不同领域和网站。

数据清洗过程:

- 移除了所谓的“不良词汇”,这些词汇被认为不适宜出现在自动完成功能中,例如色情、侮辱性或种族歧视性语言。

- 去除了代码片段,如花括号”{“等,这些通常不是自然语言的一部分。

- 利用langdetect工具排除了非英语文本,确保C4主要包含英语内容。

结果: 经过上述清洗步骤后,C4最终形成了一个包含806 GB文本数据的语料库,大约有1560亿个token。

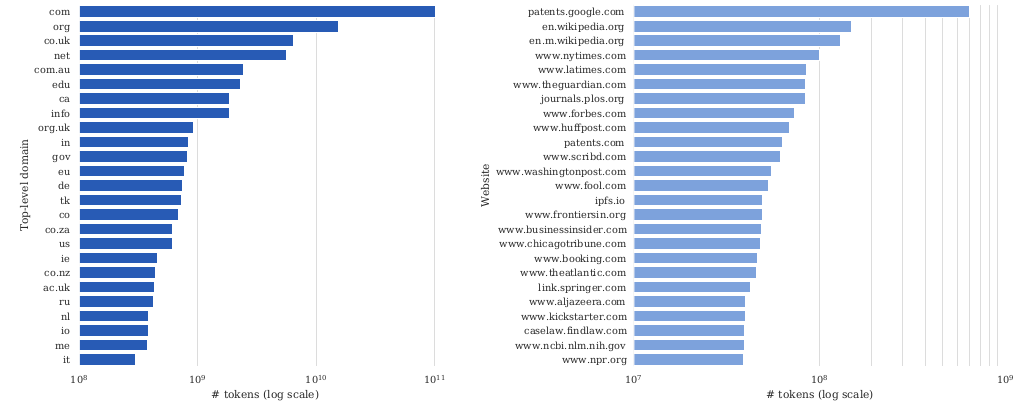

深入分析: Dodge等人在2021年的研究中对C4数据集进行了全面分析。他们从不同层面对数据集进行了文档化,以确保数据的透明度和可追溯性。

文档化级别包括:

- 元数据:记录了文本的来源和话语数据,为理解数据集提供了基础。

- 包含的数据:涵盖了机器生成或人类编写的文本,同时关注了可能存在的社会偏见和数据污染问题。

- 排除的数据:例如医疗健康数据和人口统计身份信息,这些可能涉及隐私或不适宜包含在训练数据中。

C4数据集的构建与分析凸显了在创建大规模语言模型训练集时,对数据进行精细清洗与记录的必要性,这关乎数据质量及模型的公平性。

Raffel等人 2020的工作表明,尽管提供了重建脚本,但实际运行这些脚本的成本高达数千美元。这一发现提示我们,在进行大规模数据处理时,经济成本是一个不容忽视的因素。

来自patents.google.com的数据显示,数据量之大令人瞩目:

- 65%的网页内容被收录于互联网档案馆,其中92%是近十年创作的。

- 过半数(51.3%)的网页托管于美国,尽管印度有众多英语使用者,但托管的网页数量却不多。

- 部分patents.google.com的文本内容为自动生成,存在一定的系统性偏差:

- 用非英语官方语言提交的文件常被自动翻译成英文。

- 通过光学字符识别(OCR)技术自动生成的文本。

基准数据污染问题不容忽视:

- 当使用基准数据评估大型语言模型时,若基准数据已包含在模型训练集中,其评估结果可能会被人为地提升。

- 在传统机器学习中,保持训练数据与测试数据的独立性相对容易实现。然而,对于大型语言模型,由于训练数据和基准数据多来源于互联网,确保它们的分离是一项挑战。

以XSum摘要数据集为例:

输入:一位48岁的前阿森纳守门员在皇家队效力四年。2000年,他被任命为青年学院主任,并自2003年起担任足球总监。西布朗的声明提到:“他在2006年和2012年两次关键地帮助冠军俱乐部晋级英超联赛。” 输出:西布朗任命尼克·哈蒙德为技术总监,结束了他与雷丁长达20年的深厚联系。

数据集中存在两种类型的污染:

- 输入和输出污染:输入和输出文本均出现在训练数据中,其比例从1.87%到24.88%不等,XSum数据集的比例为15.49%。

- 输入污染:仅有输入文本出现在训练数据中,比例在1.8%到53.6%之间,例如QNLI数据集,源自维基百科的页面。

值得注意的是,这种污染并非由托管数据集本身引起——它们通常存储于JSON文件中,而非作为网页存在。

数据集可能会带来一些问题,具体包括两种伤害:

-

代表性伤害:

- 数据集分析了与种族相关的词汇(如“犹太”)和带有情感色彩的词汇(如“成功”)的共现频率。

- 例如,“犹太”词汇有73.2%的正面情绪,而“阿拉伯”词汇的正面情绪为65.7%,两者相差7.5%。

- 这种差异在不同的新闻媒体中表现不一,《纽约时报》显示的差异为4.5%,而半岛电视台则为0%。

-

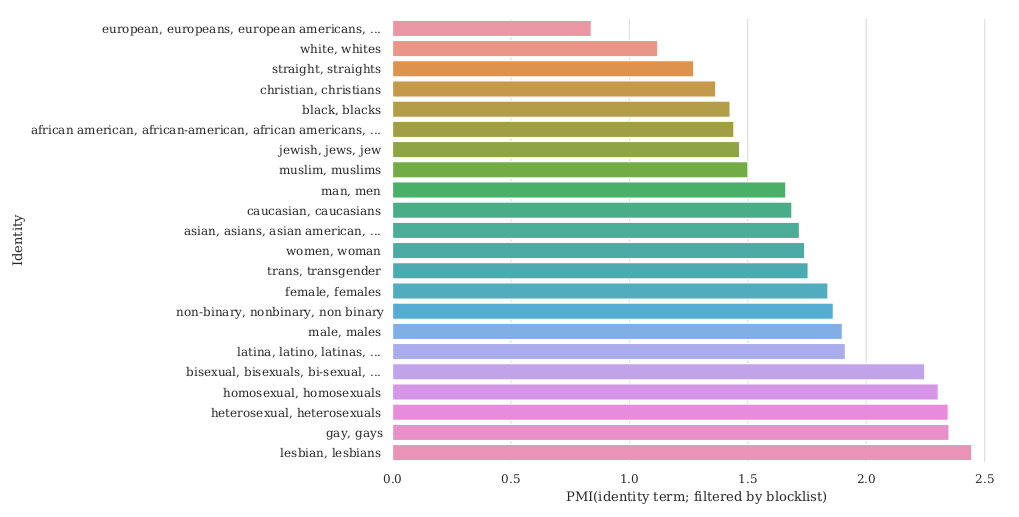

分配性伤害:

- 需要指出的是,C4数据集是基于Common Crawl数据集的一个过滤版本,只包含了大约10%的内容。

- 与性取向相关的词汇(例如“女同性恋”、“男同性恋”)更有可能在过滤过程中被排除; 而在这些被排除的内容中,有相当一部分并不具有冒犯性(分别有22%和36%的非冒犯性内容)。

- 某些方言的使用在过滤过程中也表现出不平等,如非裔美国英语被过滤的比例为42%,与西班牙裔英语对齐的英语为32%,而相比之下,美国白人英语的过滤率仅为6.2%。

这些数据集的过滤和选择可能会对研究结果的准确性和公正性产生影响。

GPT-3 数据集

段落标题 GPT-3 数据集

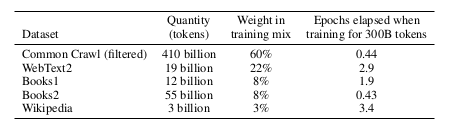

Common Crawl 子集的选择与优化:

- 选取与WebText相似的Common Crawl子集。

- 下载了2016至2019年间的41个Common Crawl分片。

- 训练了一个分类器,用以预测文档与WebText的相似度,并优先采样相似度高的文档。

数据去重与多样性提升:

- 实施了模糊去重策略,通过检测13-gram重叠,有效移除了重复内容。

- 扩展了数据源,包括WebText2、Books1、Books2和Wikipedia,以丰富数据多样性。

- 在训练过程中,对Common Crawl数据进行了下采样,优化了数据贡献率。

The Pile

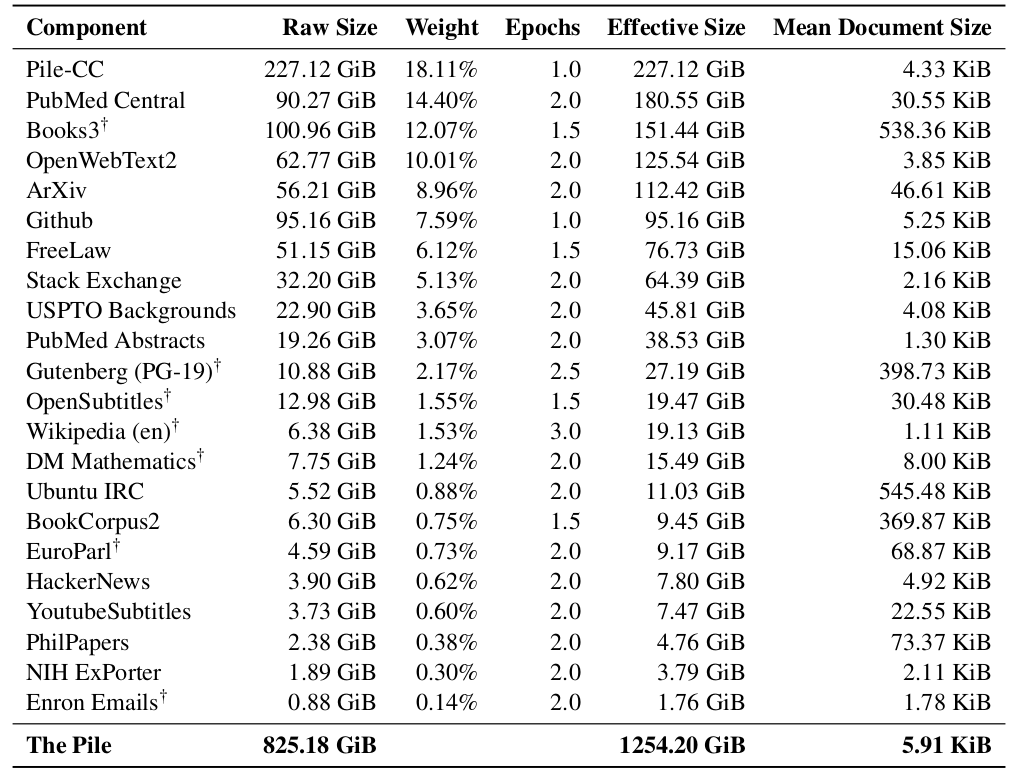

段落标题 The Pile数据集的创新与构成:

- EleutherAI组织提出了一种新策略,即从高质量小数据源(学术和专业领域)中获取数据。

- 发布了The Pile,一个专为语言建模设计的大规模数据集。

- 数据集包含825 GB的英文文本,由22个不同的高质量数据集组成。

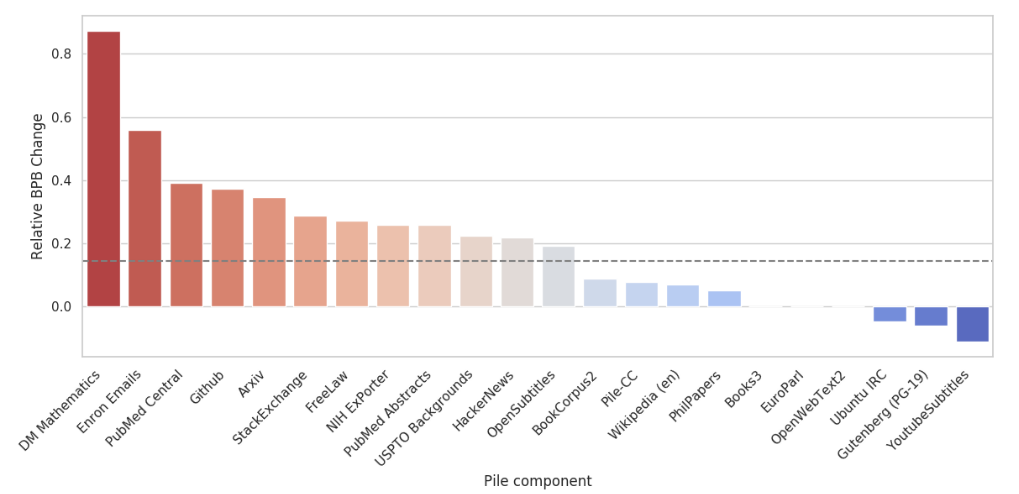

性能比较与分析:

- 对比了在The Pile上训练的GPT-2Pile模型(15亿参数)与在GPT-3数据集上训练的GPT-3模型(1750亿参数)。

- 通过标准化处理,将OpenWebText2的差异设为基准,以评估模型性能。

关键发现:

- Pile包含了GPT-3数据集未能充分覆盖的大量信息。

- 对数据集中的贬义内容、性别和宗教偏见进行了深入分析,结果与先前研究一致。

总结

段落标题 总结数据集的策略与挑战:

- 可用数据量巨大,包括网络资源和私有数据。

- 直接在全部数据上训练效果不佳,未能有效利用计算资源。

- 需要对数据进行筛选和策划,如OpenWebText、C4和GPT-3数据集,但这可能引入偏见。

- 策划非网络的高质量数据集,如Pile,是一个有前景的方向。

- 对数据集进行详细记录和审查至关重要,以确保数据的质量和适用性。

数据集的文档化

段落标题 数据集的文档化让我们暂时离开语言模型数据集的细节,来探讨数据相关的一些基本原则。

- 人们早已认识到文档化的重要性,但在机器学习领域,这通常是一个随意的过程。

- 其他行业的实践示例包括:

- 电子行业:有一套成熟的标准,每个电子元件都有详细的数据表,包括操作特性、测试结果、推荐用途等。

- 食品行业:美国食品药品监督管理局(FDA)要求食品标签上必须标明营养成分信息。

- 有关数据集文档化的重要文献,如Gebru等人在2018年的论文,为社区提供了文档化的标准。

- Bender和Friedman在2018年提出的数据声明框架,特别适用于语言数据集。

- 这些做法的核心是透明度。

文档化有两个主要目的:

- 对数据集创建者:在创建数据集时,思考决策过程和可能带来的风险(例如社会偏见)。

- 对数据集用户:明确数据集适用和不适用的情况。

数据集的生命周期涉及以下几个方面(以下是各分类下的一些示例问题):

- 动机:

- 数据集是为了什么目的创建的?

- 谁创建了这个数据集?

- 谁资助了数据集的创建?

- 组成:

- 数据集中的实例代表什么(如文档、图片、个人、国家等)?

- 有没有实例信息不完整?

- 数据集中是否包含可能被视为敏感的信息?

- 收集过程:

- 每个实例相关的数据是如何收集的?

- 谁参与了数据收集(如学生、众包工作者、承包商),他们是如何获得报酬的?

- 是否进行了任何伦理审查?

- 预处理/清洗/标注:

- 数据是否经过了预处理、清洗或标注?

- 用于这些处理步骤的软件是否可用?

- 使用情况:

- 数据集是否已经被用于某些任务?

- 有哪些任务是数据集不适宜使用的?

- 分发:

- 数据集将如何分发?

- 是否有第三方对数据施加了知识产权或其他限制?

- 维护:

- 谁将支持、托管或维护这个数据集?

- 数据集是否会定期更新?

数据声明专注于NLP数据集,还涵盖了其他方面:

- 策划理由(包含哪些内容?)

- 语言多样性(遵循BCP 47标准)

- 说话人的人口统计信息(如年龄、性别、种族/族裔等)

- 注释者的人口统计信息(如年龄、性别、种族/族裔等)

作为示例,我们可以查看The Pile数据集的数据表。

数据生态系统

段落标题 数据生态系统至今,我们的工作重点一直放在对现有大型语言模型数据集的分析和文档化上。然而,数据是一个多维度的概念,它还可以从许多不同角度进行探讨。

数据管理:在机器学习领域,我们通常将数据集看作是静态的实体,只需收集并输入到训练算法中即可。但在数据库领域,有一个专门的子领域专注于数据的生成和使用环境,这在工业界尤其重要。

- 基础模型报告中的数据部分讨论了一些相关问题。

- 数据治理关注组织如何创建数据,并确保其质量和安全性。

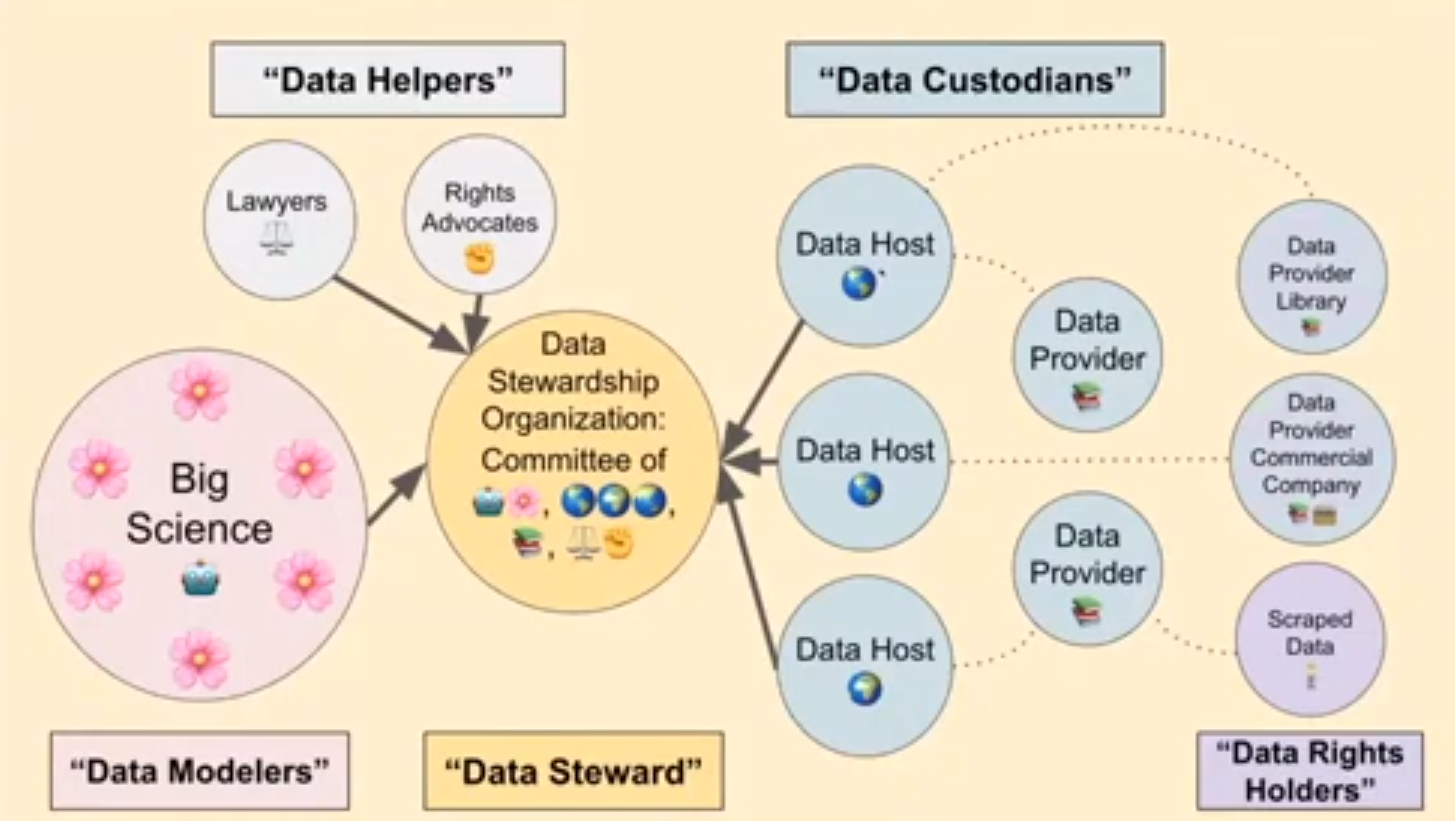

- 由Hugging Face发起的BigScience项目旨在建立大型多语种数据集并训练大型语言模型。

- BigScience数据治理工作组正在开发一套框架,目的是以负责任的方式筛选优质数据源,这与无差别地从网络抓取数据的做法不同。

数据尊严: 这个概念起源于微软和RadicalxChange,它试图深入思考数据的本质。

- 数据是由人们创造的。

- 由于人们处于社会环境中,数据不仅是个人的,也是群体的财产,例如电子邮件和基因数据。

- 单独的数据点可能没有价值,但集合起来却极具价值。

- 相关概念:数据沙普利是一个在机器学习背景下评估单个数据点价值的框架。

- 当前状况是,人们无偿地提供自己的数据,而大型企业则从中获得了巨大的价值和影响力。

- 例如,Alice和Bob都是作家。Alice无偿提供了写作样本,这些样本可以用来训练一个可能取代Bob的语言模型。

- 应该将数据视为劳动成果,而不仅仅是财产权。

- 数据隐私在个人层面上是必要的,但实际上效果有限。

- 建议成立数据联盟,这些中介组织代表数据生产者与数据购买者之间的利益(类似于集体谈判)。

- 想要了解更多信息,请阅读这篇文章。

扩展阅读

段落标题 扩展阅读数据集文档:

- Datasheets for datasets. Timnit Gebru, Jamie H. Morgenstern, Briana Vecchione, Jennifer Wortman Vaughan, H. Wallach, Hal Daumé, Kate Crawford. Communications of the ACM 2018.

- Data Statements for Natural Language Processing: Toward Mitigating System Bias and Enabling Better Science. Emily M. Bender and Batya Friedman. ACL 2018.

- Model Cards for Model Reporting. Margaret Mitchell, Simone Wu, Andrew Zaldivar, P. Barnes, Lucy Vasserman, B. Hutchinson, Elena Spitzer, Inioluwa Deborah Raji, Timnit Gebru. FAT 2018.

数据集:

- CommonCrawl

- OpenWebText Similar to WebText, used to train GPT-2.

- Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer. Colin Raffel, Noam M. Shazeer, Adam Roberts, Katherine Lee, Sharan Narang, Michael Matena, Yanqi Zhou, W. Li, Peter J. Liu. J. Mach. Learn. Res. 2019. Introduces Clossal Clean Crawled Corpus (C4) and the T5 model.

- CCNet: Extracting High Quality Monolingual Datasets from Web Crawl Data. Guillaume Wenzek, Marie-Anne Lachaux, A. Conneau, Vishrav Chaudhary, Francisco Guzm’an, Armand Joulin, Edouard Grave. LREC 2019. Introduces CCNet.

- The Pile: An 800GB Dataset of Diverse Text for Language Modeling. Leo Gao, Stella Rose Biderman, Sid Black, Laurence Golding, Travis Hoppe, Charles Foster, Jason Phang, Horace He, Anish Thite, Noa Nabeshima, Shawn Presser, Connor Leahy. 2020. Introduces The Pile. Introduces The Pile, used to train GPT-J.

- Unsupervised Cross-lingual Representation Learning at Scale. A. Conneau, Kartikay Khandelwal, Naman Goyal, Vishrav Chaudhary, Guillaume Wenzek, Francisco Guzmán, Edouard Grave, Myle Ott, Luke Zettlemoyer, Veselin Stoyanov. ACL 2019. Introduces cleaned versions of CommonCrawl corpus on 100 datasets, used to train XLM-R.

数据集分析:

- Documenting Large Webtext Corpora: A Case Study on the Colossal Clean Crawled Corpus. Jesse Dodge, Ana Marasović, Gabriel Ilharco, Dirk Groeneveld, Margaret Mitchell, Matt Gardner. EMNLP 2021.

- Quality at a Glance: An Audit of Web-Crawled Multilingual Datasets. Isaac Caswell, Julia Kreutzer, Lisa Wang, Ahsan Wahab, D. Esch, Nasanbayar Ulzii-Orshikh, A. Tapo, Nishant Subramani, A. Sokolov, Claytone Sikasote, Monang Setyawan, S. Sarin, Sokhar Samb, B. Sagot, Clara Rivera, Annette Rios Gonzales, Isabel Papadimitriou, Salomey Osei, Pedro Ortiz Suarez, Iroro Orife, Kelechi Ogueji, Rubungo Andre Niyongabo, Toan Q. Nguyen, Mathias Muller, A. Muller, S. Muhammad, N. Muhammad, Ayanda Mnyakeni, Jamshidbek Mirzakhalov, Tapiwanashe Matangira, Colin Leong, Nze Lawson, Sneha Kudugunta, Yacine Jernite, M. Jenny, Orhan Firat, Bonaventure F. P. Dossou, Sakhile Dlamini, N. D. Silva, Sakine cCabuk Balli, Stella Rose Biderman, A. Battisti, Ahmed Baruwa, Ankur Bapna, P. Baljekar, Israel Abebe Azime, A. Awokoya, Duygu Ataman, Orevaoghene Ahia, Oghenefego Ahia, Sweta Agrawal, Mofetoluwa Adeyemi. 2021.

数据集筛选:

- An Empirical Exploration in Quality Filtering of Text Data. Leo Gao. 2021.

- Deduplicating Training Data Makes Language Models Better. Katherine Lee, Daphne Ippolito, Andrew Nystrom, Chiyuan Zhang, D. Eck, Chris Callison-Burch, Nicholas Carlini. 2021.

数据生态系统:

- Foundation models report (data section)

- BigScience data governance working group

- Data Shapley: Equitable Valuation of Data for Machine Learning. Amirata Ghorbani, James Y. Zou. ICML 2019.

- Data Freedom Act